Das Vakuum ist leer, oder? Oder doch nicht? Zumindest nicht für Quantenphysiker. Denn diese gehen davon aus, dass selbst hier noch Teilchen und Anti-Teilchen fluktuieren. Bisher gibt es für diese Annahme noch keinen eindeutigen Beweis. Doch schon die deutschen Physiker Werner Heisenberg und Hans Euler vermuteten Lichtinteraktionsprozesse im vermeintlichen Nichts. Nun haben sich Forschungsgruppen der Universität Jena, des Helmholtz-Instituts Jena (HIJ), der Universität Düsseldorf und der Ludwig-Maximilians-Universität München (LMU) zum Ziel gesetzt, physikalische Prozesse im Quantenvakuum erstmals experimentell nachzuweisen.

LICHT MACHT PHÄNOMENE IM „LEEREN RAUM“ SICHTBAR

„Starke Felder bringen die Quanten zum Wackeln.“ So in etwa beschreiben die Experten ihr Forschungsziel für nicht-Physiker. Genauer gesagt wollen sie Quantenvakuumprozesse, die den Grundzustand der Natur bilden, mit Hochintensitätslasern nachweisen. „Das Besondere an unserem Team ist das enge Zusammenspiel von fundamentaler Theorie und hoher Experimentierkunst“, erläutert Dr. Felix Karbstein, Theoretiker am HIJ. Karbstein arbeitet an der genauen Vorhersage für Messgrößen, in denen die im Vakuum extrem kurz entstehenden Teilchen und ihre Anti-Teilchen ihre Spuren hinterlassen.

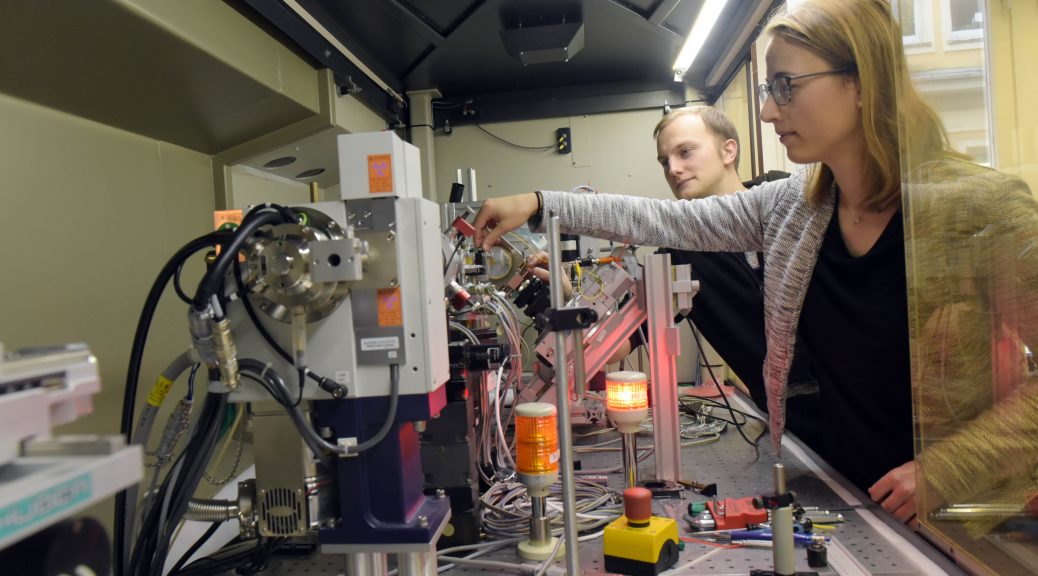

Die Jenaer Experimentalphysiker sowie die Kollegen an der LMU forschen derweil an einer Methodik, um den praktischen Nachweis zu erbringen. Dazu entwickeln und kombinieren sie leistungsstarke Laser mit neuartigen, präzisen Messverfahren. So sollen die flüchtigen Prozesse im Vakuum gemessen werden können. Denn bislang existierten keine Lichtquellen, die für eine experimentelle Überprüfung leistungsfähig genug waren. Die modernen Hochintensitätslaser, die bei den Versuchen zum Einsatz kommen, nähern sich inzwischen der notwendigen Laserleistung. Daher werden die Experimente nicht nur in Jena und München, sondern auch am Europäischen Röntgenlaser bei DESY in Hamburg durchgeführt.

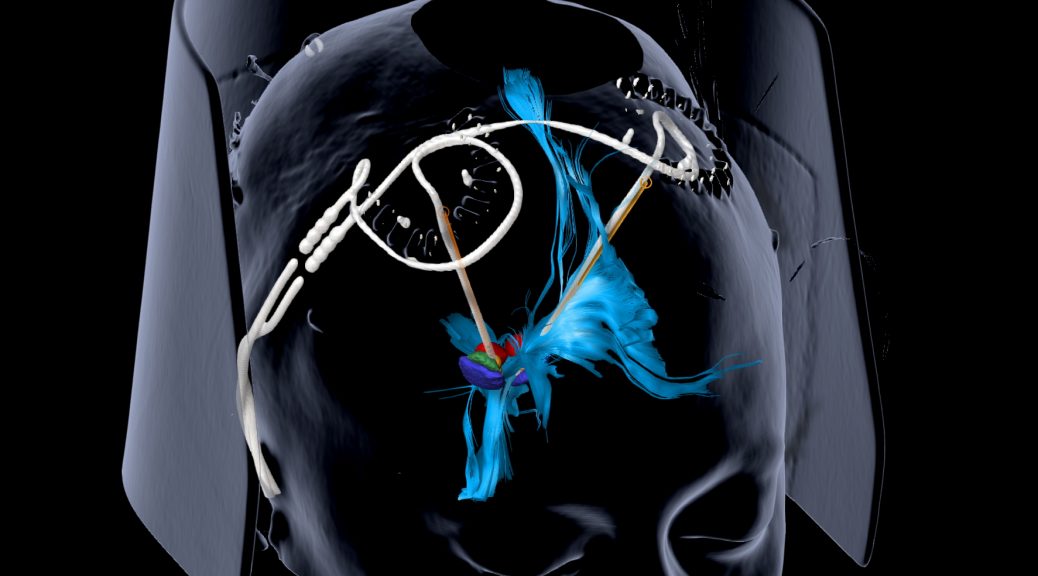

Die moderne Physik sieht die Phänomene des Quantenvakuums, die Gies und sein Team beweisen wollen, als fundamental und exotisch zugleich an. Dazu zählen beispielsweise die multiphotonische Erzeugung von Teilchenpaaren aus dem Vakuum sowie Streuphänomene des Lichts, wie die sogenannte Quantenreflexion. Diesen schwer zu fassenden Ereignissen ist jedoch nicht nur die Jenaer Forschungsgruppe auf der Spur. „Wir befinden uns in einem internationalen Wettbewerb“, weiß Prof. Dr. Holger Gies, Quantentheoretiker und Leiter der Forschungsgruppe. Der Physiker hofft ‒ da er von den Fähigkeiten seiner experimentellen Kollegen überzeugt ist ‒, dass die Forschungsgruppe aufgrund der besonderen Nähe von Theorie und Praxis den Nachweis als erstes führen kann.

EIGENSCHAFTEN DES VAKUUMS ALS BAUSTEINE NUTZEN

Nicht nur für die Quantenphysik selbst ist der Nachweis und das Verständnis der Vakuumphänomene von Bedeutung. Die Ergebnisse könnten in Zukunft bei der Entwicklung von Geräten helfen, die die Eigenschaften des Vakuums als Bausteine nutzen. So sind beispielsweise moderne Hochleistungslaser und präzise Messmethoden auch aus der Medizin, den Lebenswissenschaften und der Materialforschung nicht mehr wegzudenken. „Bei der Erforschung des Quantenvakuums kommen wir Grundlagenforscher einer konkreten Anwendung somit vergleichsweise nahe“, so Gies. Andererseits bestehe sogar die Möglichkeit, Hinweise auf Kandidaten für die rätselhafte Dunkle Materie zu finden. Diese wiederum ist für die Strukturbildung im Universum verantwortlich. Sie könnte aber auch im Quantenvakuum Spuren hinterlassen. Doch nun gilt es erst einmal die erhofften Ergebnisse zu realisieren. Also nachzuweisen, dass es selbst im Zustand niedrigster Energie physikalische Prozesse gibt.

Das Forschungsprojekt namens „Probing the Quantum Vacuum at the High-intensity Frontier“ ist auf sechs Jahre angelegt. Wobei die erste, dreijährige Phase von der Deutschen Forschungsgemeinschaft mit rund zwei Millionen Euro und insgesamt neun Doktorandenstellen finanziert wird.

Bild oben: Annika Schmitt und Benjamin Grabiger von der Universität Jena arbeiten hier an einem Polarimeter, um die benötigten Präzisionsmessverfahren zu verbessern. ©Jan-Peter Kasper/FSU