Es gibt viele Faktoren, bei denen vermutet wird, dass sie zum Krebswachstum beitragen. Stress ist einer davon. Doch Stress ist subjektiv, also schwer zu messen. Bis jetzt beriefen sich Studien, die den Zusammenhang von Stress und Krebs herstellten, auf empirische Daten. Ein exakter wissenschaftlicher Beweis blieb offen. Denn eine große Herausforderung in der Erforschung wie auch in der Behandlung von metastasierendem Brustkrebs ist die Tumorheterogenität. Im Verlauf der Erkrankung wird der Tumor nämlich vielfältiger. Somit können die wachsenden Unterschiede zwischen den einzelnen Krebszellen zu einem unzureichenden Therapieerfolg führen. Unbekannt waren dabei bis dato die zu Grunde liegenden Mechanismen dieses Phänomens.

FORSCHUNG ANHAND VON MAUS-KREBSMODELL

Forschende der Universität Basel sowie des Universitätsspitals Basel deckten kürzlich die molekularen Mechanismen auf, die Brustkrebsmetastasen mit erhöhten Stresshormonen verbinden. Für ihre Studien untersuchten die Wissenschaftler rund um Prof. Mohamed Bentires-Alj die Form des sogenannten dreifach negativen Brustkrebses. Er ist eine besonders aggressive Krebsart, dessen Name sich durch die bei ihm nicht vorhandenen Rezeptoren ‒ also dem Östrogenrezeptor, Progesteronrezeptor oder HER-2-Rezeptor ‒, anhand derer die Oberfläche der Krebszellen eingeteilt wird, ableitet. Der dreifach negative Krebs ist resistent gegen Standardtherapien und bietet für die Patientinnen weniger Behandlungsmöglichkeiten.

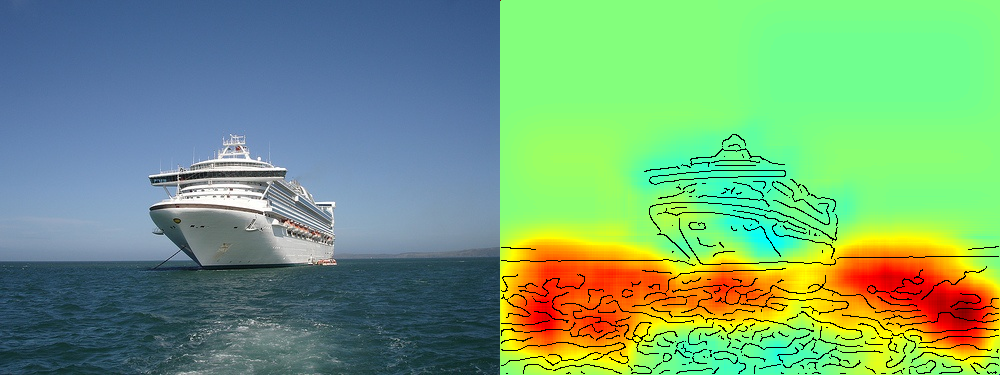

Ihre Forschungen nahmen die Wissenschaftler an einem Maus-Krebsmodell vor. Um hier die Heterogenität zwischen Tumoren und Metastasen zu untersuchen, erforschten sie die Aktivität von Genen. Dabei stellten sie fest, dass Metastasen eine erhöhte Aktivität bei den sogenannten Glukokortikoid-Rezeptoren (GR) verzeichnen. Diese binden Stresshormone wie etwa Cortisol.

Mäuse mit Metastasen hatten höhere Konzentrationen von Stresshormonen als Mäuse ohne Metastasen. Die Studie zeigt, dass erhöhte Stresshormonlevels die GR aktivieren. Dies führt wiederum zu einer verstärkten Kolonisierung und Heterogenität der Krebszellen. Was letztendlich eine verkürzte Lebensdauer mit sich bringt.

NEUE THERAPIEN DENKBAR

Die GR binden auch synthetische Derivate von Cortisol. Dazu gehören zum Beispiel der Entzündungshemmer Dexamethason, der oft eingesetzt wird, um die Nebenwirkungen der Chemotherapie zu lindern. Die Forschungsergebnisse zeigten, dass Dexamethason die Wirksamkeit des Medikaments Paclitaxel, welches vielfach in der Chemotherapie Verwendung findet, beeinträchtigen kann.

Die Ergebnisse der Baseler Forschungsgruppe weisen darauf hin, dass bei der Verschreibung von Glukokortikoid-Hormonen an Patientinnen mit Brustkrebs Vorsicht geboten ist. Auch macht die Studie deutlich, dass die Blockierung der GR von Vorteil sein kann. Sie könnte zudem zur Entwicklung neuer Therapien für die Bekämpfung der Metastasierung von Brustkrebs führen.

„Die Tumorheterogenität ist ein großes Hindernis bei der Behandlung“

…, betont Prof. Bentires-Alj. Und er fährt fort: „Die Bedeutung von Stressmanagement kann nicht überbetont werden – insbesondere bei Patientinnen mit dreifach negativem Brustkrebs.“ Er empfiehlt betroffenen Patientinnen deshalb ein moderates Bewegungstraining sowie Entspannungstechniken. Nicht nur laut Bentires-Alj ist dies nachweislich mit einer verbesserten Lebensqualität und erhöhten Lebenserwartung verbunden.

Die Studie wurde kürzlich im International Journal of Science Nature veröffentlicht. Prof. Bentires-Alj ist übrigens zusammen mit Prof. Walter Paul Weber, Chefarzt der Abteilung für Brustchirurgie am Universitätsspital Basel, Gründer des Brustkonsortiums Basel.

Bild oben: Gezieltes Stressmanagement in Verbindung mit einem moderaten Bewegungstraining und Entspannungstechniken sind nachweislich mit einer verbesserten Lebensqualität und erhöhter Lebenserwartung der Patientinnen verbunden ©yogakalyanii by Pixabay

DIESER ARTIKEL KÖNNTE SIE AUCH INTERESSIEREN

Innovationen, die die Krebsbehandlung verändern werden:

(1) Gentherapie mit Clostridien