Wissenschaftler des Forschungszentrums Jülich und der Westfälischen Wilhelms-Universität Münster entwickelten eine neue Festkörperbatterie. Das Besondere: Sie verfügt über eine Anode aus reinem Lithium. Das Alkalimetall gilt als ideales Elektrodenmaterial, da sich mit ihm die höchsten Energiedichten erreichen lassen. Doch da das Metall sehr reaktiv ist, wurde es bisher nicht als Anode verwendet. Die Forschenden tricksten diese Eigenschaft jedoch durch den Einsatz von zwei zusätzlichen Lagen aus einem neuartigen Polymer aus. Diese schützen den keramischen Elektrolyten der Batterie und verhindern somit, dass sich das Metall auf zerstörerische Weise ablagert. In Labortests waren über Hunderte von Ladezyklen möglich, ohne dass die Zellen deutlich an Kapazität verloren.

BEDEUTENDE ZUKUNFT ERWARTET

Feststoffbatterien gelten übrigens als eine bedeutende Entwicklung für die Zukunft. Ihr besonderer Vorteil: Festkörperakkus enthalten keine Flüssigkeiten, die auslaufen oder in Brand geraten können. Aus dem Grund sind sie deutlich sicherer, zuverlässiger und langlebiger als aktuelle Lithium-Ionen-Batterien mit flüssigem Elektrolyt. Gleichzeitig besitzen Festkörperbatterien das Potenzial, mehr Energie auf demselben Raum bei geringerem Gewicht zu speichern. Entsprechend wird erwartet, dass diese Technologie verschiedenen Bereichen zum Durchbruch verhelfen könnte. Mögliche Einsatzszenarien sind die Elektromobilität, aber auch Nischenanwendungen in der Medizin- sowie Raumfahrttechnik sind denkbar.

„Ziel war es, unser Konzept für eine Festkörperbatterie so zu erweitern, dass der stabile Betrieb mit einer Lithium-Anode möglich wird, und das haben wir geschafft“, freut sich Dr. Hermann Tempel vom Jülicher Institut für Energie- und Klimaforschung (IEK-9) über die aktuellen Ergebnisse. Lithium als Anode gilt als Material der Wahl, wenn es darum geht, möglichst hohe Energiedichten zu erzielen. Denn das leichteste Metall ist gleichzeitig auch das elektronegativste aller chemischen Elemente.

Die neue Festkörperbatterie kommt bezogen auf beide Elektroden auf eine Energiedichte von 460 Wh/kg. Im Vergleich mit aktuellen Lithium-Ionen-Batterien ist das ein sehr guter Wert. Hinzu kommen weitere Vorteile, die die Bauweise mit sich bringt. So sind Festkörperbatterien deutlich weniger temperaturempfindlich als herkömmliche Lithium-Ionen-Batterien mit Flüssigelektrolyt. Daher benötigen sie keine Vorrichtungen für das Temperaturmanagement, wie sie bislang in Elektroautos verbaut werden, was zusätzlich Gewicht einsparen dürfte.

POLYMERFOLIE ALS SCHUTZSCHICHT

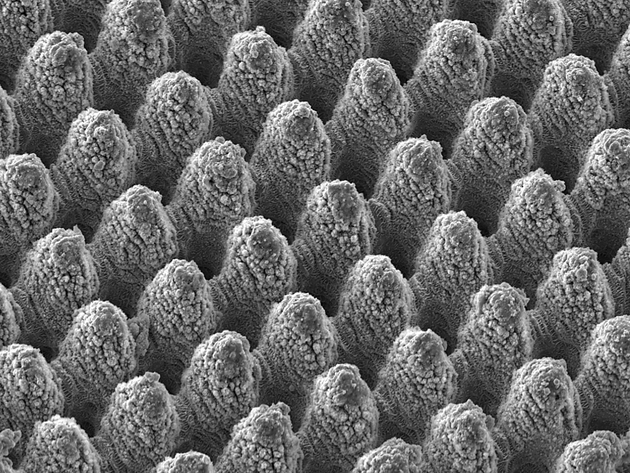

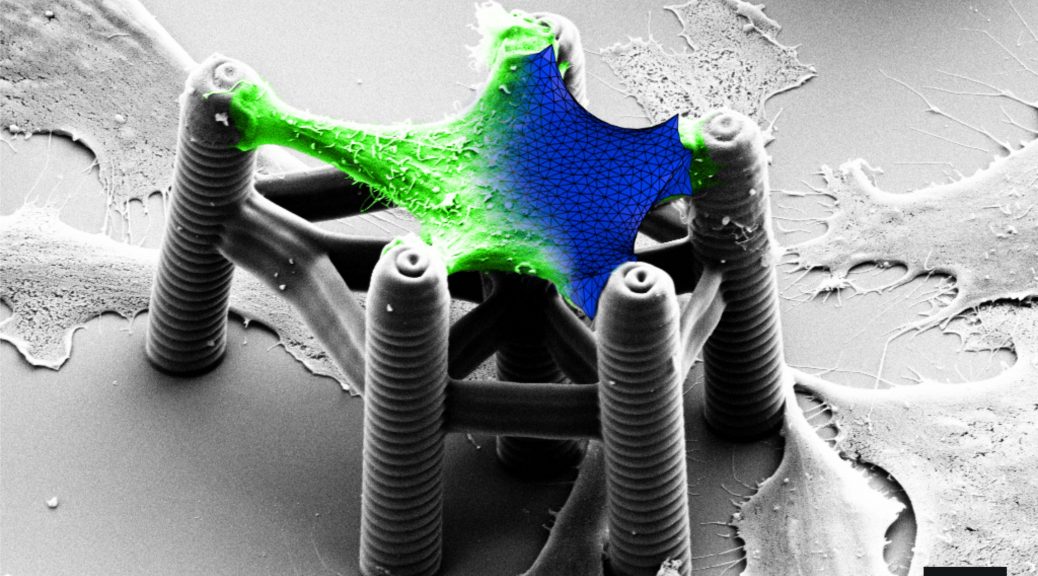

Möglich wurde die Verwendung einer Anode aus reinem Lithium durch den Einbau einer Polymerfolie zwischen Anode und Elektrolyt. Reines Lithium neigt dazu, beim Laden unkontrollierte Auswüchse auszubilden. Diese sogenannten Dendriten können die Zelle kurzschließen oder sie mechanisch zerstören. In der Anode heutiger Lithium-Ionen-Akkus werden Lithium-Atome daher in einem Speichermedium, meist Graphit, eingelagert. Das Gewicht der Elektrode und der gesamten Batterie erhöht sich dadurch um ein Vielfaches.

„Das Polymer funktioniert wie eine Schutzschicht, die die Verwendung einer Lithium-Anode überhaupt erst möglich macht“, erklärt Tempel. „Sie verhindert, dass der keramische Elektrolyt in direkten Kontakt mit dem metallischen Lithium an der Anode kommt. So werden schädliche Prozesse wie die Dendritenbildung und chemische Veränderungen des keramischen Elektrolyten unterbunden, die die Funktion der Batterie beeinträchtigen.“ Erste Tests im Labor verliefen bereits sehr erfolgreich. Über 500 Lade- und Entladezyklen hinweg ließen sich kaum Performanceeinbußen feststellen.

„Das Besondere an der Zelle ist, dass sie trotz der moderat leitenden Polymere funktioniert; in mancher Hinsicht sogar besser als ohne“, konstatiert Professor Hans-Dieter Wiemhöfer vom Helmholtz-Institut Münster (HI MS), der das spezielle Polymer, das zu der Klasse der Polyphosphazene zählt, entwickelt hat. Wiemhöfer koordiniert das BMBF-Verbundprojekt MEET-HiEnD II, aus dem die neue Batterie hervorgegangen ist.

Die Polymerschicht wird bei der Herstellung flüssig aufgetragen. Sie dringt dabei tief in den porösen keramischen Elektrolyten ein. Das verbessert den Kontakt zwischen dem festen Elektrolyt und der festen Elektrode – bei Festkörperakkus ein häufiges Problem. Mit diesem Verfahren wird kein stabiles und entsprechend schweres Gehäuse benötigt, das die verschiedenen Komponenten mechanisch zusammenpresst und dadurch für eine gute Verbindung sorgt. Das spart ebenfalls Gewicht und trägt dazu bei, die Energiedichte zu erhöhen.

DOPPELTE ENERGIEDICHTE ABER LÄNGERE LADEZEIT

Als zusätzliche Barriere zwischen den einzelnen Komponenten wirken sich die Polymerschichten jedoch auch nachteilig auf die Performance der Batterie aus, insbesondere auf den Stromfluss. Im letzten Jahr hatten Jülicher Wissenschaftler eine gut funktionierende, schnellladefähige Festkörperbatterie vorgestellt, die innerhalb einer halben Stunde ge- und entladen werden kann. Mittels Lithium-Anode und Hybridelektrolyt ist es ihnen nun zwar gelungen, die theoretische Energiedichte zu verdoppeln. Die Ladezeit verlängerte sich dadurch jedoch auf zwei Stunden. Für Festkörperbatterien ist das immer noch ein guter Wert.

Auch andere Aspekte zeigen: Die Batterie ist noch in einem frühen Entwicklungsstadium und nur begrenzt reif für die Praxis. So muss die Zelle im Betrieb momentan auf einer Mindesttemperatur von 50 Grad Celsius gehalten werden, damit der hybride Elektrolyt für Ladungsträger durchlässig bleibt. „Für niedrigpreisige Anwendungen ist das Herstellungsverfahren bis jetzt auch noch zu aufwendig. Die funktionierende Zelle zeigt aber, dass es der Hybridelektrolyt ermöglicht, typische Probleme an den Grenzflächen von Festkörperbatterien zu umgehen“, erklärt Professor Rüdiger-A. Eichel, Institutsleiter am Forschungszentrum Jülich (IEK-9). Für Nischenanwendungen, bei denen Kosten eine nicht so große Rolle spielen, ist die inhärent sichere Batterie mit der hohen Energiedichte möglicherweise jetzt schon interessant. „Aber auch für kostenkritische Anwendungen wie die Elektromobilität birgt der Ansatz großes Potenzial.“

Die Arbeit entstand im BMBF-Verbundprojekt MEET-HiEnD II, in dem die Westfälische Wilhelms-Universität Münster, das Forschungszentrum Jülich und die RWTH Aachen zusammenarbeiten. Die Originalpublikation wurde in der Ausgabe 8/2019 im Journal of Materials Chemistry Averöffentlicht.

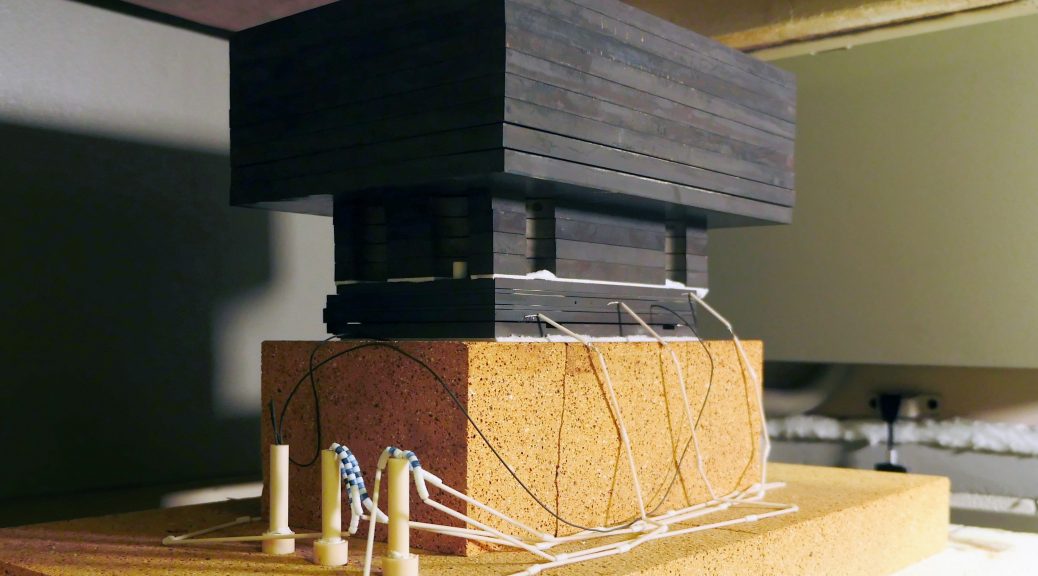

Bild oben: Die Komponenten der Lithium-Festkörperbatterie mit Hybridelektrolyt noch im Laborstadium ©Forschungszentrum Jülich / T.Schlößer

Dieser Artikel erschien am 27.2.2019 in der Innovation Origins.

DAS KÖNNTE SIE AUCH INTERESSIEREN

Europa setzt bei der Batterieproduktion auf Nachhaltigkeit